HELM产品简介

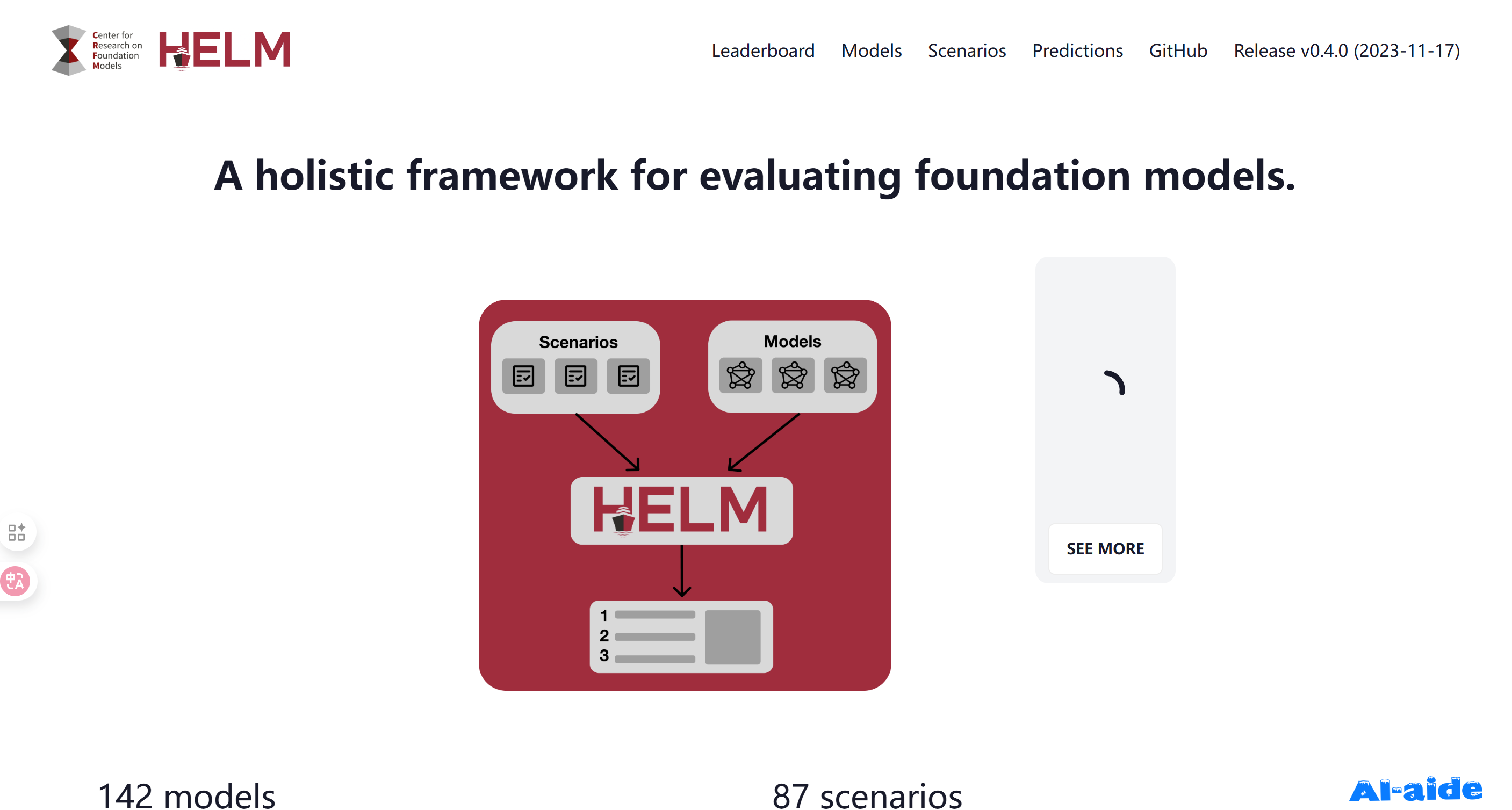

HELM(Holistic Evaluation of Language Models,语言模型整体评估)是由斯坦福大学基础模型研究中心(CRFM)推出的大模型全维度评测体系,核心定位为 “覆盖性能、伦理、效率的全方位 AI 能力评估方法论与工具集”。它打破传统大模型评测 “任务片面、指标单一、落地脱节” 的痛点,以 “全链路刻画模型能力边界” 为核心目标,通过 “场景、适配、指标” 三大核心模块构建标准化评测流程。聚焦英语场景,覆盖问答、信息检索、文本分类等多元任务,整合准确率、鲁棒性、公平性、毒性、推断效率等多维度指标,搭配开源工具链与可视化平台,为语言模型的研发优化、合规验证、学术研究提供科学系统的评估支撑,成为全球大模型评测领域的标杆体系。

HELM核心功能及特点

HELM核心功能:覆盖语言模型全场景全维度评估需求

“场景 - 适配 - 指标” 三维驱动,构建标准化评测流程:

场景模块:从 “任务、领域、语言” 三维矩阵定义评估场景,涵盖 16 个核心场景模板,任务维度包含自然语言理解与生成、工具调用等,领域维度覆盖医疗、金融、长文本等垂直场景,语言维度以英语为核心并延伸至多语言场景。用户可根据需求自定义场景,如新增 “医疗术语问答” 等垂直任务,确保评测与实际应用对齐。

适配模块:提供模型提示工程适配能力,针对不同模型特性(如开源模型、闭源 API 模型)设计标准化提示模板,支持零样本、少样本等适配策略,解决不同模型接口差异导致的评测偏差问题,确保跨模型对比的公平性。

指标模块:构建四层递进式指标体系,从基础性能到伦理安全全面覆盖:基础性能指标(准确率、精确匹配等)衡量核心能力;模型特性指标(鲁棒性、校准度等)评估稳定性;伦理安全指标(毒性生成率、偏见度等)规避落地风险;效率指标(推理耗时、碳排放等)平衡工程成本,彻底跳出 “唯准确率论” 的局限。

多元任务覆盖,适配英语场景全需求:深度聚焦英语评测场景,适用问答(SQuAD 基准)、信息检索、文本分类(SST-2 任务)、代码补全、长文本摘要等多元任务类型。内置 100 + 标准任务数据集,涵盖通用领域与垂直行业场景,可满足不同研发阶段的模型能力验证需求,如通过对抗样本测试模型的鲁棒性表现。

开源工具链与可视化平台,降低评测门槛:提供官方开源工具crfm-helm,支持一键安装与流程化操作,具备模型接口统一、指标自动计算、结果可视化等功能。通过 Web UI 可直观查看单条样本结果与模型能力热力图,同时支持自定义任务配置,即使非专业技术人员也能快速开展评测,实现 “评估 - 分析 - 优化” 的闭环。

权威榜单输出,直观呈现行业格局:维护多维度官方排行榜,包括能力总榜、安全专项榜、领域垂直榜(如医疗、金融)等,覆盖 GPT-4o、Claude-3.5、Qwen2 等主流模型。榜单按场景与指标细分呈现,清晰展示不同模型的优势与短板,为选型决策提供客观参照。

HELM产品特点

评估全面性:从任务场景到伦理安全,从技术性能到工程效率,实现 “全维度无死角” 评估,远超传统单一指标评测;

方法论先进:三维场景矩阵与四层指标体系的设计逻辑严谨,贴合大模型从研发到落地的全生命周期需求;

开源可复现:核心工具与数据集完全开源,评测流程透明可复现,支持本地部署与二次开发,保障结果公信力;

伦理导向鲜明:首次将毒性、偏见、隐私保护等伦理指标纳入核心评估维度,助力合规化 AI 研发;

落地适配性强:兼顾推理耗时、碳排放等工程指标,评估结果可直接指导模型部署优化,避免 “实验室高分、落地失效” 问题。

HELM适用人群

大模型研发团队与算法工程师:AI 企业研发人员可通过全维度指标定位模型短板,如利用鲁棒性测试优化对抗样本处理能力,借助效率指标平衡性能与部署成本,加速模型迭代升级;

学术研究与科研工作者:高校人工智能领域师生可利用标准化框架验证新算法的有效性,依托伦理指标开展 AI 公平性研究,借助开源工具复现权威论文结果,支撑高质量学术产出;

企业合规与技术决策者:金融、医疗等合规敏感行业的技术负责人,可通过毒性、偏见等指标评估模型合规风险,结合效率指标选择适配业务场景的模型,降低落地隐患;

开源社区开发者与技术爱好者:可基于crfm-helm工具开发自定义评测场景,或参与数据集共建,在实践中深化对大模型能力边界的理解,同时为社区生态贡献力量;

AI 政策制定与行业观察者:行业分析师与政策研究者可通过定期更新的榜单数据掌握全球大模型发展格局,结合伦理指标研究 AI 监管方向,为产业规划提供数据支撑。